Enam bulan setelah mengungkapkan GPU server unggulan baru. Nvidia memberi peningkatan memori sambil juga meluncurkan GPU server dan hardware Mellanox untuk solusi perangkat keras dan jaringan yang kuat yang ditujukan untuk para peneliti. Pembangun superkomputer dan / atau raksasa cloud.

GPU A100 80GB Nvidia

GPU server A100 Nvidia sekarang dapat dibeli dengan memori HBM2e berkecepatan tinggi 80GB. Dua kali lebih banyak dari sebelumnya – perusahaan mengumumkan pada Senin pagi.

Sebagai perbandingan, GPU gaming Nvidia yang paling kuat, GeForce RTX 3090 dan 3080. Masing-masing mengemas 24GB dan 10GB, dari memori grafis GDDR6X.

Selain terjual secara mandiri, penawaran A100 80GB melalui server DGX A100 Nvidia dan baseboard server HGX A100. Yang dapat mengemas hingga 8 GPU A100 yang terhubung melalui interkoneksi NVLink milik Nvidia. Secara alami, ini juga akan mendukung solusi DGX SuperPod Nvidia untuk membangun superkomputer yang mempercepat GPU dengan cepat.

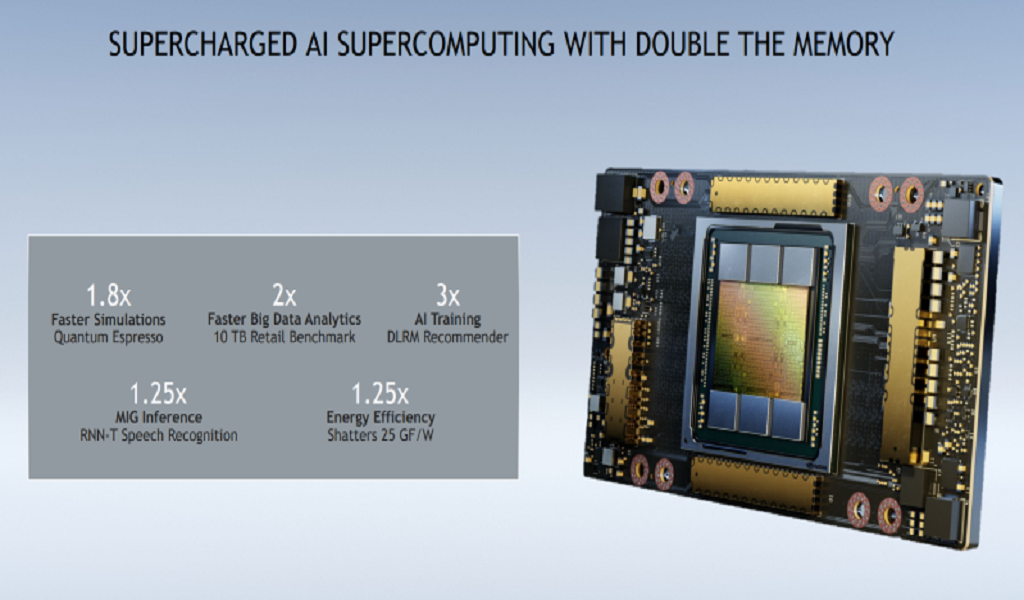

Nvidia mengklaim peningkatan memori A100 memungkinkan peningkatan kinerja utama untuk berbagai pelatihan model AI, komputasi kinerja tinggi (HPC) dan beban kerja analitik data.

Sekaligus meningkatkan kinerja inferensi AI dan memungkinkan GPU menjadi lebih hemat daya. Apa adanya, 40GB A100 – GPU pertama berdasarkan arsitektur Ampere Nvidia. Memberikan keuntungan kinerja raksasa untuk pelatihan, inferensi dan ke tingkat yang lebih rendah, beban kerja HPC tradisional relatif terhadap pendahulunya, Tesla V100.

Stasiun DGX A100

Bersama dengan 80GB A100, Nvidia meluncurkan DGX Station A100, server grup kerja yang kuat untuk peneliti AI / HPC yang. Dengan bantuan sistem pendinginan canggih – telah menempatkan ke dalam faktor bentuk desktop. Stasiun DGX A100 mengemas empat GPU A100 80GB atau 40GB dan (menggemakan DGX A100 standar, yang memiliki dua di antaranya) CPU server AMD Epyc 64-core.

BMW, Lockheed Martin, dan operator seluler Jepang NTT Docomo akan menjadi salah satu pembeli pertama Stasiun DGX A100. Ketiga perusahaan berencana menggunakan server untuk membantu upaya penelitian AI mereka.

“Biasanya, ketika pelanggan ingin membangun superkomputer, mereka merencanakannya, dan kemudian butuh berbulan-bulan atau bertahun-tahun untuk membangun. Dan hal pertama yang menjadi pertanyaan pengguna mereka adalah.

‘Kapan saya bisa mendapatkan node pertama, sehingga saya dapat melakukan pengembangan perangkat lunak?’,” kata seorang perwakilan Nvidia. “Nah sekarang… Anda bisa mendapatkan node pertama Anda [segera], karena [Stasiun DGX A100 memiliki] papan GPU yang sama persis yang masuk ke superkomputer yang Anda bangun.”

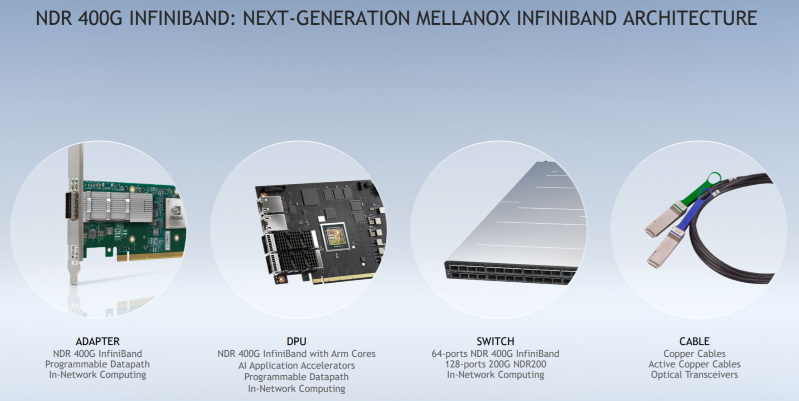

Interkoneksi hardware Mellanox 400-Gig

Unit interkoneksi server Mellanox Nvidia meluncurkan banyak produk baru – yang secara kolektif menjadi sebagai jalur InfiniBand NDR 400G – yang mendukung koneksi InfiniBand 400 Gb / s. Hingga saat ini, penawaran InfiniBand paling kuat dari Mellanox telah menduduki puncaknya sebesar 200 Gb/dtk.

Jajaran InfiniBand 400 manggung hardware Mellanox dengan perkiraan akan mulai melakukan sampling pada kuartal kedua 2021. Peluncuran pada saat ini — karena CEO Nvidia Jensen Huang telah menekankan. Koneksi jaringan sering muncul sebagai hambatan untuk penanganan node server yang menuntut beban kerja AI dan HPC dengan bantuan GPU atau akselerator lainnya.

Jajaran NDR 400G InfiniBand mencakup kartu adaptor 400-gig dan sakelar 64-port yang menjanjikan memiliki kepadatan port switch tiga kali pendahulunya.

Ada juga unit pemrosesan data (DPU) 400 gig yang memasangkan fungsi adaptor jaringan dengan core CPU Arm yang dapat membongkar berbagai fungsi pemrosesan jaringan, penyimpanan dan keamanan. Serta kabel tembaga dan transceiver optik yang dapat menangani koneksi 400-gig.

Microsoft , yang telah bekerja sama dengan Nvidia dan Mellanox untuk menyediakan akses sesuai permintaan ke sumber daya superkomputer melalui instans komputasi cloud Azure, menunjukkan akan mendukung jalur InfiniBand NDR 400G.

Penawaran 400 manggung Mellanox sedang terungkap dua bulan setelah Nvidia mengumumkan kesepakatannya untuk membeli Arm. Dan sebulan setelah Nvidia menguraikan peta jalan ambisius untuk meluncurkan 200-gig dan (akhirnya) 400-gig DPUs yang memanfaatkan inti CPU Arm dan GPU terintegrasi untuk membongkar fungsi dari CPU server.

Nvidia tetap menjadi pemain dominan di pasar akselerator AI dan akselerator HPC/superkomputer, dan juga merupakan pemain utama di pasar yang sedang berkembang untuk akselerator server inferensi AI. Interkoneksi InfiniBand dan Ethernet Mellanox juga merupakan pemandangan umum dalam superkomputer dan pusat data cloud.

Pengumuman Nvidia datang di tengah konferensi superkomputer SC20, dan menjelang laporan pendapatan kuartal Oktober yang jatuh tempo pada Rabu sore. Nvidia execs akan menyampaikan presentasi SC20 di 6 P.M. Eastern Time pada hari Senin untuk pergi ke penawaran terbaru perusahaan mereka.