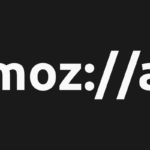

Kemampuan sebuah robot, meniru hewan asli setelah yang mana mereka cenderung dirancang selalu jauh lebih baik. Itu sebagian karena sulit untuk belajar berjalan seperti anjing langsung dari anjing. Tetapi penelitian dari laboratorium AI Google ini membuat anjing robot jauh lebih mudah.

Tujuan dari penelitian ini, sebuah kolaborasi dengan UC Berkeley, adalah untuk menemukan cara untuk secara efisien dan otomatis mentransfer “perilaku lincah”. Seperti berlari kecil atau berputar dari sumbernya (anjing yang baik) ke robot quadrupedal. Hal semacam ini telah dilakukan sebelumnya, tetapi seperti yang ditunjukkan oleh posting para peneliti. Proses pelatihan yang telah mapan seringkali “membutuhkan banyak wawasan dari para ahli. Dan seringkali melibatkan proses penyetelan hadiah yang panjang untuk setiap keterampilan yang diinginkan.”

Itu tidak diatur dengan skala yang baik, secara alami, tetapi penyetelan manual diperlukan untuk memastikan pergerakan hewan didekati dengan baik oleh robot. Bahkan robot yang sangat seperti anjing tidak benar-benar seekor anjing. Dan cara seekor anjing bergerak mungkin tidak persis seperti yang seharusnya dilakukan robot, membuat robot yang jatuh, terkunci atau gagal.

Proyek Google dengan Anjing Robot

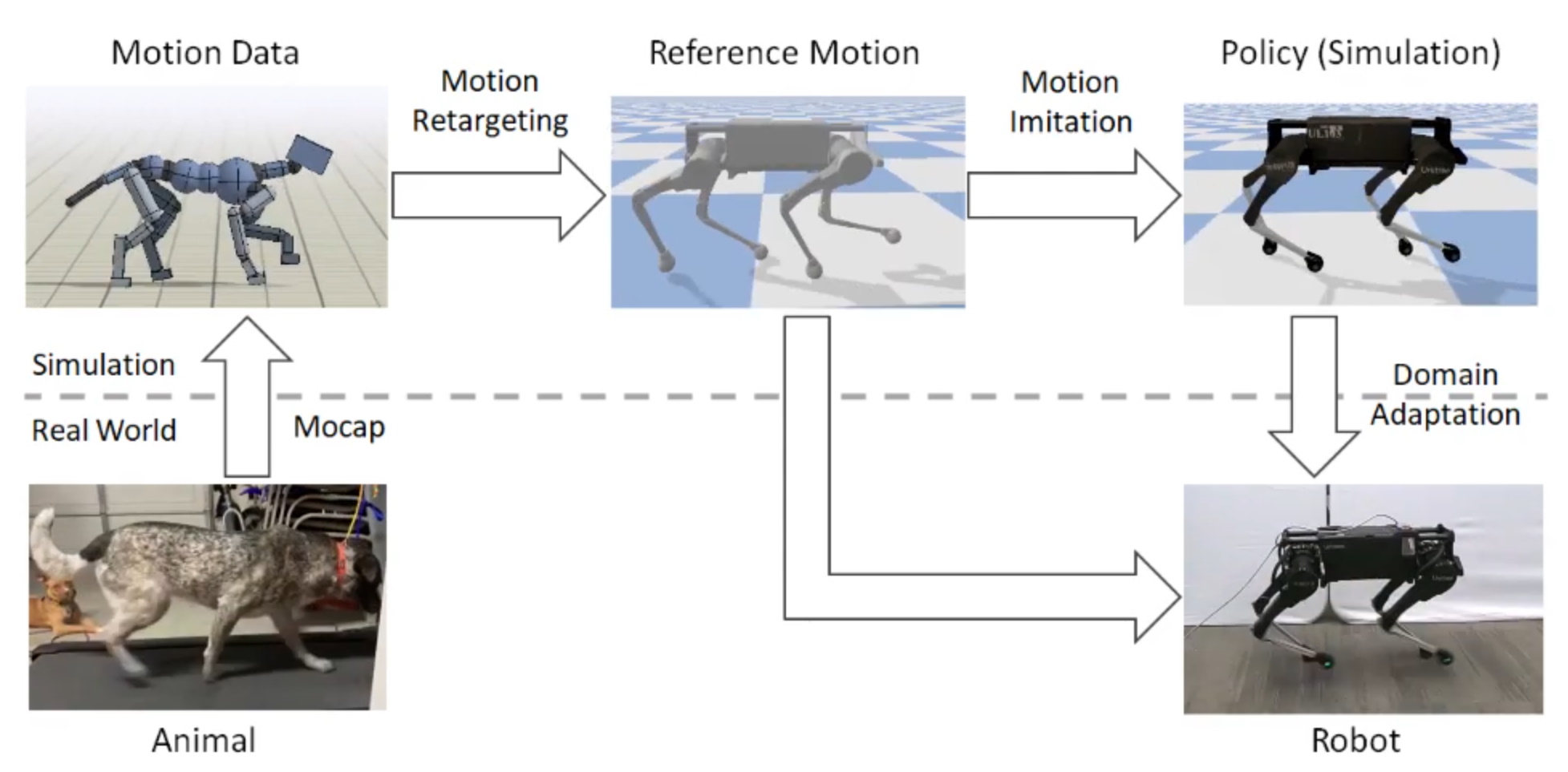

Proyek Google AI mengatasinya dengan menambahkan sedikit kekacauan yang terkontrol ke urutan normal. Biasanya, gerakan anjing akan ditangkap dan titik kunci seperti kaki dan persendian akan dilacak dengan cermat. Poin-poin ini akan didekati ke robot dalam simulasi digital, di mana versi virtual robot berusaha untuk meniru gerakan anjing dengan caranya sendiri, sambil belajar.

Sejauh ini, sangat bagus, tetapi masalah sebenarnya muncul ketika Anda mencoba menggunakan hasil simulasi itu untuk mengendalikan robot yang sebenarnya. Dunia nyata bukan pesawat 2D dengan aturan gesekan yang ideal dan sebagainya. Sayangnya, itu berarti bahwa simulasi berbasis simulasi yang tidak dikoreksi cenderung membawa robot ke tanah.

Untuk mencegah hal ini. Para peneliti memperkenalkan unsur keacakan ke parameter fisik yang digunakan dalam simulasi, membuat (anjing) robot virtual lebih berat. Atau memiliki motor yang lebih lemah, atau mengalami gesekan yang lebih besar dengan tanah. Hal ini membuat model pembelajaran mesin yang menggambarkan bagaimana berjalan harus memperhitungkan semua jenis varian kecil dan komplikasi yang mereka buat – dan bagaimana cara menangkalnya.

Belajar mengakomodir data acak itu membuat metode berjalan yang dipelajari jauh lebih kuat di dunia nyata. Yang mengarah pada tiruan jalan anjing target yang lumayan. Dan bahkan gerakan yang lebih rumit seperti belokan dan putaran, tanpa intervensi manual dan hanya sedikit virtual tambahan latihan.

Tweak manual secara alami masih dapat ditambahkan ke dalam campuran jika diinginkan. Tetapi seperti berdiri ini adalah peningkatan besar atas apa yang sebelumnya bisa dilakukan secara otomatis.

Materi dukungan

Dalam proyek penelitian lain yang dijelaskan dalam pos yang sama, seperangkat peneliti lain menggambarkan (anjing) robot yang belajar sendiri untuk berjalan sendiri. Tetapi diilhami dengan kecerdasan untuk menghindari berjalan di luar area yang ditentukan dan untuk bangkit ketika jatuh. Dengan keterampilan dasar yang tertanam, robot mampu berjalan di sekitar area pelatihannya terus menerus tanpa intervensi manusia, belajar keterampilan gerak yang cukup terhormat.

Makalah tentang belajar kelincahan perilaku dari hewan dapat dibaca di sini, sedangkan yang di robot belajar berjalan sendiri (kolaborasi dengan Berkeley dan Institut Teknologi Georgia) ada di sini.