Apple mengatakan memperkenalkan fitur keselamatan anak baru di iOS, iPadOS, watchOS, dan macOS sebagai bagian dari upayanya untuk membatasi penyebaran konten pelecehan seksual anak (CSAM) di AS.

Untuk efek itu, pembuat iPhone mengatakan bermaksud untuk memulai pemindaian sisi klien gambar yang dibagikan melalui setiap perangkat Apple untuk konten pelecehan anak.

Selain memanfaatkan pembelajaran mesin di perangkat untuk memeriksa semua gambar iMessage yang dikirim. Atau diterima oleh akun kecil (berusia di bawah 13 tahun) untuk memperingatkan orang tua tentang foto seksual eksplisit yang dibagikan melalui platform perpesanan.

Selain itu, Apple juga berencana untuk memperbarui Siri dan Search untuk menggelar intervensi ketika pengguna mencoba melakukan pencarian untuk topik terkait CSAM. Memperingatkan bahwa “minat dalam topik ini berbahaya dan bermasalah.”

“Pesan menggunakan pembelajaran mesin di perangkat untuk menganalisis lampiran gambar dan menentukan apakah foto eksplisit secara seksual,” Apple mencatat. “Fitur ini memiliki rancangan agar Apple tidak mendapatkan akses ke pesan.”

Fitur tersebut, bernama Communication Safety, dikatakan sebagai pengaturan opt-in yang harus diaktifkan oleh orang tua melalui fitur Keluarga Berbagi.

Bagaimana konten pelecehan seksual anak terdeteksi

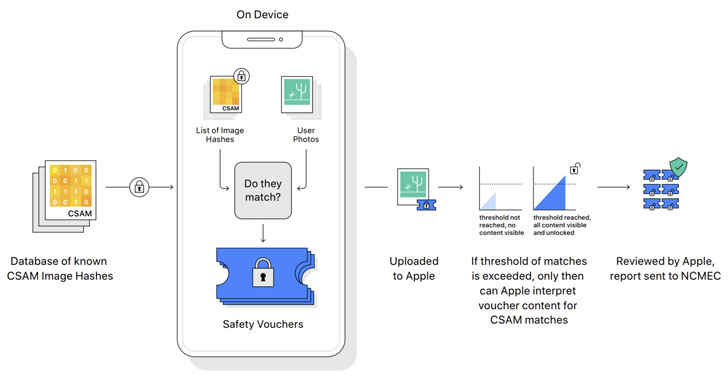

Deteksi gambar CSAM melibatkan melakukan pencocokan di perangkat menggunakan database hash gambar CSAM yang tersedia oleh National Center for Missing and Exploited Children (NCMEC) dan organisasi keselamatan anak lainnya.

“NeuralHash,” seperti yang disebut sistem, memiliki dukungan oleh teknologi kriptografi yang terkenal sebagai persimpangan set pribadi.

Namun, yang menjadi catatan bahwa saat pemindaian terjadi secara otomatis, fitur hanya berfungsi saat berbagi foto iCloud aktif.

Apple harusnya menggunakan prinsip kriptografi lain yang bernama threshold secret sharing yang memungkinkannya untuk “menafsirkan” konten jika akun Foto iCloud melewati ambang batas citra pelecehan anak.

Setelah itu konten mengalami peninjauan secara manual untuk mengonfirmasi ada kecocokan. Dan jika demikian, nonaktifkan akun pengguna, laporkan materi ke NCMEC, dan menyampaikannya kepada penegak hukum.

Peneliti menyatakan keprihatinan tentang privasi

Inisiatif CSAM Apple telah mendorong para peneliti keamanan untuk mengekspresikan kecemasan bahwa ia dapat menderita misi merayap. Dan mampu untuk mendeteksi jenis konten lain yang dapat memiliki implikasi politik dan keselamatan.

Atau bahkan membingkai individu yang tidak bersalah dengan mengirimi mereka gambar yang tidak berbahaya. Tetapi berbahaya yang rancangannya untuk muncul sebagai kecocokan untuk pornografi anak.

Whistle-blower AS Edward Snowden men-tweet bahwa, terlepas dari niat baik proyek, apa yang Apple rilis adalah “pengawasan massal”.

Sementara profesor kriptografi dan pakar keamanan Universitas Johns Hopkins Matthew Green mengatakan, “masalahnya adalah bahwa enkripsi adalah alat yang kuat yang memberikan privasi. Dan Anda tidak dapat benar-benar memiliki privasi yang kuat sambil juga mengawasi setiap gambar yang dikirim siapa pun.”

Apple sudah memeriksa file dan gambar iCloud yang terkirim melalui email terhadap citra pelecehan anak. Seperti halnya raksasa teknologi seperti Google, Twitter, Microsoft, Facebook, dan Dropbox. Yang menggunakan metode hashing gambar serupa untuk mencari dan menandai materi penyalahgunaan potensial.

Tetapi upaya perusahaan untuk berjalan di tali privasi dapat memperbarui perdebatan tentang melemahkan enkripsi. Meningkatkan tarik ulur perang yang telah berjalan lama atas privasi dan kepolisian di era digital.